Warum dieser Artikel?

Einleitung

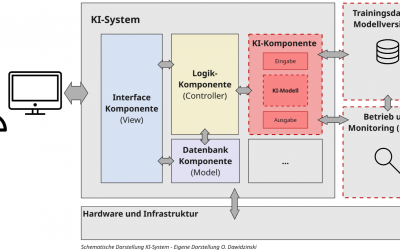

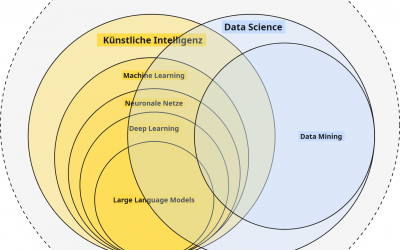

Im Beitrag „KI-Kompetenz (Teil 2): Der Unterschied zwischen KI, Data Science und Co.“ ging es um die Beschreibung von KI und deren Abgrenzung zu verwandten Themengebieten. In diesem Beitrag möchte ich auf die relevanten Arten und Kategorien von KI-Systemen eingehen, denn KI ist nicht gleich KI.

In der Praxis erweist es sich als erstaunlich schwierig, KI-Systeme zu unterscheiden oder zu kategorisieren, da die Grenzen zwischen verschiedenen KI-Ansätzen, Verfahren und Anwendungsbeispielen fließend sind.

Diese Unterscheidung ist jedoch entscheidend für die Entwicklung vertrauenswürdiger und verantwortungsvoller KI, da sie die Grundlage für die Ermittlung und Bewertung von Risiken, die Zuweisung von Rechenschaftspflichten und die Gewährleistung von Fairness und Sicherheit bildet. Ohne ein klares Verständnis davon, um was für eine Art von KI-System es sich handelt und wie dieses (grob) funktioniert, können wir weder seine Chancen voll ausschöpfen noch seine Risiken wirksam steuern.

In diesem Beitrag möchte ich deshalb auf zwei zentrale Kategorien und Unterscheidungsmerkmale von KI und KI-Systemen eingehen, welche meiner Meinung nach von großer Bedeutung für die Bewertung und den Einsatz von vertrauenswürdiger und verantwortungsvoller KI in der Praxis sind.

Letztes Update am 25.11.2025

Inhalt und Aufbau des Artikels

In diesem Artikel möchte ich auf folgende Punkte eingehen:

Welche Arten und Kategorien von KI gibt es?

Bevor wir auf die zwei zentralen KI-Kategorien eingehen, ist es zunächst hilfreich, einen Überblick zu bekommen, welche unterschiedlichen Kategorisierungsarten aktuell verbreitet sind.

Wenn man sich Autos anschaut, so kann man diese nach Leistung, Farbe, Anbieter, Wartbarkeit, Ausstattung, Sicherheit, Verwendungszweck oder ganz eigenen Kriterien einteilen. Letztendlich handelt es sich um Transport- oder Fortbewegungsmittel, und am Ende sucht man sich das Auto aus, welches den persönlichen oder individuellen Bedürfnissen und Anforderungen am ehesten entspricht.

Ähnlich verhält es sich in der Praxis auch mit KI-Systemen. Für unterschiedlichste Problem- und Aufgabenstellungen gibt es eine Vielzahl möglicher KI-Systeme, Modelle oder Ansätze. Diese lassen sich ebenfalls nach unterschiedlichsten Kriterien kategorisieren. So können KI-Systeme z. B. nach den verwendeten Technologien oder Architekturen, ihrem Aufgabenschwerpunkt, Funktionsweise, ML-Verfahren oder dem Ausgabeformat eingeteilt werden.

Die geläufigsten Klassen bzw. Kategorien, nach welchen KI-Systeme oder Modelle aktuell unterschieden werden, sind in der Regel die folgenden:

Die Unterscheidung nach dem Grad der Intelligenz (Performance & Generalisierungsfähigkeiten) – Dazu zählen z. B.:

-

Schwache KI

-

Starke KI

-

(Super-KI)

Die Unterscheidung nach der Lernfähigkeit und Art der Entscheidungsfindung – Darunter fallen:

-

Reaktive Maschinen (Reactive Machines)

-

KI mit begrenztem Gedächtnis (Limited Memory AI)

-

Theorie des Geistes (Theory of Mind)

-

Selbstbewusste KI (Self-Aware AI)

Nach den jeweiligen Lernmethoden (Machine Learning), wie dem:

-

Supervised Learning

-

Unsupervised Learning

-

Semi-Supervised Learning

-

Reinforcement Learning

-

…

Nach der Architektur und dem Algorithmus – Z. B.:

-

Statistische Modelle

-

Entscheidungsbäume

-

Support-Vector-Machines

-

Künstliche Neuronale Netze

-

Large Language Models (Encoder-Only, Encoder-Decoder, Decoder-Only)

-

…

Nach (allgemeiner) Funktionsweise:

-

Diskriminative KI

-

Generative KI

Nach Aufgabengebiet bzw. Anwendungszweck: Z. B. KI zur:

-

Bild-, Text- oder Audiogenerierung

-

Klassifikation

-

Zeitreihenprognose

-

Regression

-

Optimierungsprobleme

-

Empfehlungsgenerierung

-

etc.

Man sieht bereits, dass es viele Schnittmengen und mehrfache Zuordnungsmöglichkeiten gibt. Die Kategorisierung, die man wählt, hängt im Grunde von der Person und dem gewählten Schwerpunkt ab. So macht für Endanwender z. B. eine Kategorisierung nach Aufgaben bzw. Verwendungszweck häufig am meisten Sinn, da man in der Regel mit KI ein Problem lösen möchte. Ein Data Scientist oder ML-Engineer wird ggf. KI-Systeme nach der jeweiligen Lernmethode oder den zu verwendenden Algorithmen einordnen. Für einen Risikomanager oder KI-Beauftragten werden wiederum andere Faktoren für eine Einordnung relevant sein.

Und damit sind wir wieder beim Thema der vertrauenswürdigen und verantwortungsvollen KI. Um einordnen zu können, ob ein KI-System vertrauenswürdig und verantwortungsvoll ist, braucht es in der Regel das Wissen aus verschiedenen der genannten Kategorien und ein tiefgehendes Verständnis über die Datengrundlage sowie ausführliche Prüfungen. Eine pauschale Einordnung anhand der genannten Klassen wäre damit nur schwer möglich.

Dennoch gibt es zwei Klassen, die meiner Meinung nach sowohl mit Blick auf verantwortungsvolle und vertrauenswürdige KI als auch für technische sowie nicht-technische Stakeholder relevant sind und eine praxisnahe Einordnung von KI-Systemen ermöglichen: die Unterscheidung nach dem Grad der Intelligenz (Unterschied zwischen starker und schwacher KI) und der allgemeinen Funktionsweise (der Unterschied zwischen diskriminativer und generativer KI).

Der Unterschied zwischen schwacher und starker KI

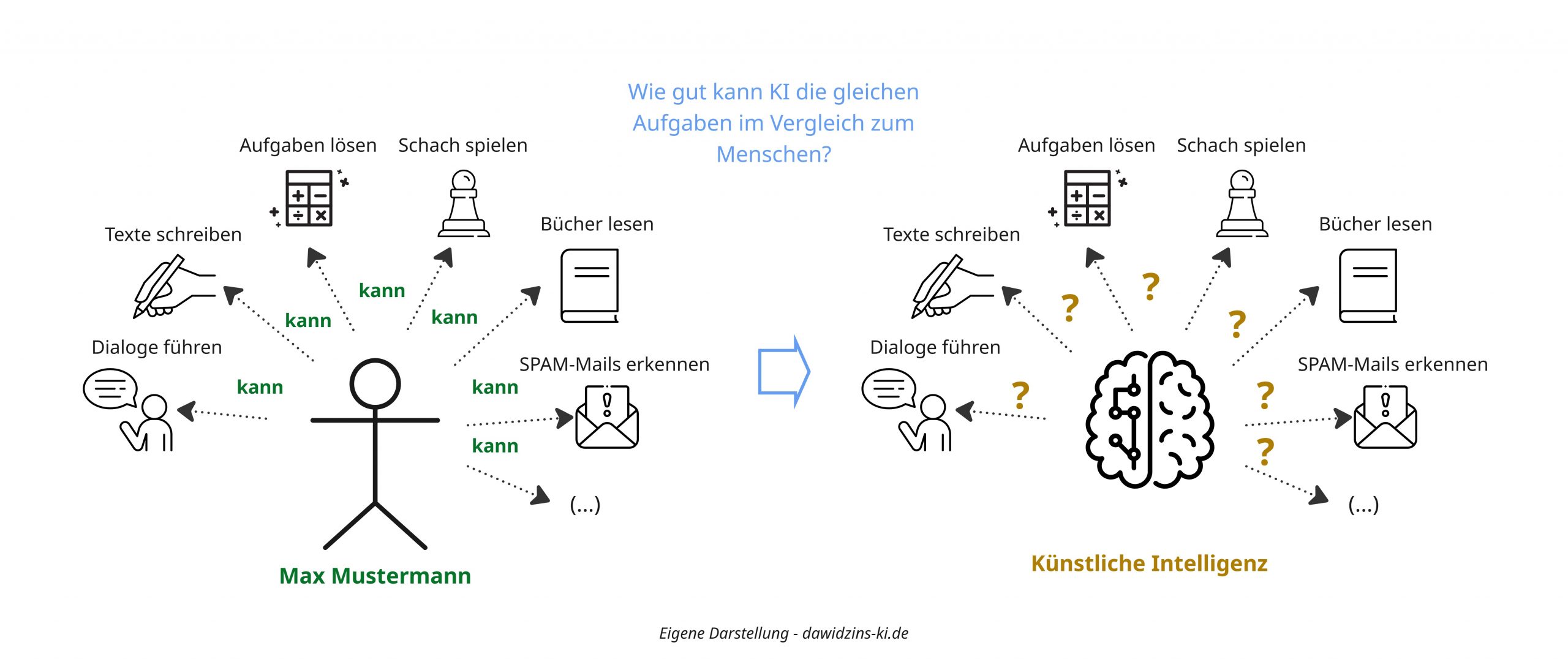

Der Kern der Unterscheidung zwischen schwacher und starker KI liegt in der Bewertung und Einordnung anhand der Fähigkeiten eines KI-Systems und daran, wie gut es diese im Vergleich zum Menschen ausführen kann. Man vergleicht also die Fähigkeiten von KI-Modellen mit denen von Menschen und prüft, wie „intelligent“ diese im Vergleich zum Menschen sind. Dieses Vorgehen geht auf das Paper „Levels of AGI for Operationalizing Progress on the Path to AGI“ (arXiv:2311.02462 [cs.AI]) zurück und ist sehr nützlich, da es uns anhand eines Reifegradmodells erlaubt, KI-Systeme und deren Fähigkeiten mit denen des Menschen zu vergleichen und einzuordnen.

Doch fangen wir damit an, wie schwache und starke KI in dieser Unterscheidung definiert sind:

Schwache KI (Narrow AI) umfasst KI-Systeme, die nur eine oder eine fest definierte Anzahl an Aufgaben oder Fähigkeiten beherrschen und nicht generisch sind. Eine schwache KI ist zum Beispiel nur in der Lage, Aufgaben auszuführen, für die sie im Vorfeld eindeutig entwickelt oder trainiert wurde, wie z. B. Preise zu prognostizieren oder E-Mails zu klassifizieren. Sie kann nicht ohne weiteres für beliebige andere Aufgaben verwendet werden oder gar neue Aufgaben selbständig lernen.

Starke KI (General AI) umfasst dagegen KI-Systeme, die grundsätzlich in der Lage sind, mehr als eine Aufgabe zu beherrschen oder sogar neue zu lernen, und das ohne eine spezielle manuelle Anpassung oder Veränderung. Sie können damit „generalisieren“ bzw. sind „Generalisten“. So kann eine starke KI sowohl für die E-Mail-Klassifikation als auch das Übersetzen von Texten eingesetzt werden, auf Wunsch auch noch ein Gedicht schreiben oder sogar neue Fähigkeiten „lernen“. Für den ein oder anderen wird wahrscheinlich bereits klar sein, dass dies stark nach KI-Assistenten wie ChatGPT, Gemini und Co. klingt – und tatsächlich sind dies klassische Beispiele für starke KI nach dieser Definition.

Mit dieser Definition haben wir eine Beschreibung und Einordnung des Fähigkeitsumfangs von KI-Systemen. Jedoch fehlt noch ein wichtiger Punkt: die Bewertung ihrer Fähigkeiten oder ihres Grades an „Intelligenz“. Zu diesem Zweck haben die Autoren ein Reifegradmodell mit 6 Stufen (0-5) definiert, das die menschlichen Fähigkeiten als Vergleichswert heranzieht. Das bedeutet, dass verglichen wird, wie gut ein KI-System eine Aufgabe im Vergleich zu einem Menschen mit verschiedenen Erfahrungsstufen ausführen kann.

Dabei sind die Reifegradstufen wie folgt definiert:

Stufe 0 – Keine KI: Nicht alles ist KI. Anwendungen, die nach von Menschen vorher festgelegten Regeln funktionieren oder durch einen Menschen gesteuert Entscheidungen treffen sowie Ergebnisse generieren, sind im Reifegradmodell auf Stufe 0 eingeordnet und entsprechen damit keinem KI-System im engeren Sinne.

-

Typische Beispiele können sein: Word- oder Excel, Anwendungen, die durch Menschen bedient und gesteuert werden (z. B. ein Bestellsystem, CRM), Browser etc.

Stufe 1 – Emerging AI (Aufstrebende KI-Systeme): Aufstrebende KI-Systeme bilden die erste Stufe im Reifegradmodell. Sie sind dadurch charakterisiert, dass sie Aufgaben gleichwertig oder leicht besser erfüllen können als ein untrainierter Mensch. Das bedeutet, wenn ich als Mensch noch nie E-Mails klassifiziert habe und dies von heute auf morgen als Aufgabe übernehmen soll, dann könnte ein KI-System auf Stufe 1 diese Aufgabe genauso gut oder sogar leicht besser erfüllen als ich.

-

Beispiel: Wenn ich 5 von 10 Spam-Mails korrekt erkenne (50 %), dann würde ein KI-System der Stufe 1 diese Quote ebenfalls erreichen.

Stufe 2 – Competent AI (Kompetente KI-Systeme): Kompetente KI-Systeme bilden die zweite Stufe im Reifegradmodell und beschreiben KI-Systeme, die in der Lage sind, Aufgabenstellungen genauso gut oder besser lösen zu können wie 50 % der menschlichen Experten. Umgekehrt wären damit nur 50 % der menschlichen Experten genauso gut oder besser wie die KI.

-

Beispiel: Ich schaue mir eine Gruppe von menschlichen KI-Experten und deren Erkennungsrate von Spam-E-Mails an und stelle fest, dass diese im Median (50 %-Perzentil) eine Erkennungsrate von 60 % (6 von 10 Spam-Mails erkannt) erreichen. Ein KI-System der Stufe 2 müsste nun ebenfalls eine Erkennungsrate von 60 % aufweisen und wäre damit so gut wie mindestens 50 % der menschlichen Experten.

Stufe 3 – Expert AI (Experten-KI-Systeme): KI-Systeme der Stufe 3 werden als Experten betrachtet. Sie sind in der Lage, Aufgabenstellungen genauso gut zu lösen wie 90 % der menschlichen Experten. Umgekehrt wären nur 10 % der menschlichen Experten in der Lage, die Aufgabe besser als das KI-System zu lösen.

-

Beispiel: Am Beispiel der Spam-Erkennung wäre ein KI-System der Stufe 3 in der Lage, die Aufgabe mit einer Genauigkeit zu erledigen, wie sie nur die besten 10 % der menschlichen Experten erreichen könnten. Wenn das 90 %-Perzentil bei 7 von 10 korrekt erkannten Spam-Mails liegt, hätte das KI-System damit eine Genauigkeit von 70 %, die nur die besten 10 % der menschlichen Experten erreichen.

Stufe 4 – Virtuoso AI („Meisterhafte“ KI-Systeme): „Meisterhafte“ KI-Systeme der Stufe 4 setzen noch eins drauf und sind in der Lage, eine Genauigkeit bei der Ausführung einer Aufgabe zu erreichen, wie sie nur 1 % der menschlichen Experten erreichen könnten. „Meisterhafte“ KI-Systeme sind damit besser als 99 % der menschlichen Experten.

-

Beispiel: Wenn das 99 %-Perzentil bei 8 von 10 korrekt erkannten Spam-Mails liegt, würde ein virtuoses KI-System mit einer Genauigkeit von 80 % arbeiten und wäre damit genauso gut wie die besten 1 % der menschlichen Experten.

Stufe 5 – Superhuman AI (Übermenschliche KI): Die letzte Stufe bildet die Superhuman AI. „Übermenschliche“ KI umfasst Systeme, die in der Lage sind, Aufgaben besser oder genauer als alle menschlichen Experten auszuführen.

-

Beispiel: Die besten menschlichen Experten erkennen nur in 9 von 10 Fällen Spam-Mails korrekt. Niemand schafft 10 von 10 und damit 100 %. Ein KI-System der Stufe 5 wäre in der Lage, 100 % zu erreichen und jede Spam-Mail korrekt zu erkennen. Es wäre damit besser als der Mensch.

Anhand der Leistungsstufen (Performance) sowie der Generalisierungsfähigkeiten (schwach/stark) lassen sich nun KI-Systeme sehr gut klassifizieren. Man sieht bereits, dass insbesondere die schwachen (spezialisierten) KI-Systeme in vielen Aufgabengebieten bereits Aufgaben und Problemstellungen deutlich besser lösen können als Menschen. Dafür sind diese in der Regel auf einen Aufgabentyp beschränkt und nicht universell einsetzbar. Anders sieht es bei starken (generalistischen) KI-Systemen wie ChatGPT, Gemini und Co. aus, die zwar deutlich flexibler und für unterschiedlichste Anwendungsfälle einsetzbar sind, jedoch (dadurch) gleichzeitig in ihrer Leistungsfähigkeit eingeschränkt und häufig hinter spezialisierten Modellen zurückstehen.

Da es sich bei ChatGPT und Co. aktuell in der Regel um sogenannte generative KI-Systeme handelt, führt uns dies direkt zur zweiten Unterscheidungskategorie.

Der Unterschied zwischen diskriminativer (prädiktiver) KI und generativer KI

Während bei der Unterscheidung zwischen schwacher und starker KI die Leistungs- und Generalisierungsfähigkeiten von KI-Systemen im Vordergrund stehen, konzentriert sich die Unterscheidung zwischen diskriminativer und generativer KI im Kern auf die Funktionsweise und Art der Ausgaben.

Diskriminative KI

Bei diskriminativer KI (häufig auch prädiktive KI genannt) handelt es sich um KI-Modelle (Diskriminatoren), die während ihres Entwicklungsprozesses (Training) darauf trainiert wurden, Daten (Objekte) auf Basis ihrer Merkmale möglichst genau zu unterscheiden und damit zu klassifizieren. Die Algorithmen dieser Modelle versuchen im Training, die Beziehung zwischen Eingabedaten (x) und den jeweiligen Ausgabekategorien (y) der Trainingsdaten zu lernen. Dabei lernen sie intern sogenannte „Entscheidungsgrenzen“ (häufig in Form von bedingten Wahrscheinlichkeiten), durch die einzelne Objektklassen voneinander „abgegrenzt“ werden können.

Als Ausgabe (Inferenz) geben solche Modelle dann in der Regel Wahrscheinlichkeiten oder Konfidenzwerte aus, die beschreiben, wie hoch die Zugehörigkeit eines Eingabedatensatzes (Objektes) zu einer der im Training gelernten Klassen ist.

Beispiel E-Mail-Klassifikation

Das Ganze lässt sich wieder gut am Beispiel der E-Mail-Klassifizierung betrachten: Wir wollen automatisiert herausfinden, ob eine E-Mail SPAM oder KEIN SPAM ist. Es handelt sich dabei um ein binäres Klassifikationsproblem. Als Ausgangsdaten (Trainings- und Evaluierungsdaten) haben wir hunderte von E-Mails sowie deren manuelle Einteilung (Annotation) in „SPAM“ oder „NO SPAM“. Die Inhalte und Metadaten der E-Mails (Text, Absender, Uhrzeit) sind dabei unsere Eingabemerkmale (x). Die Einteilung in „SPAM“ oder „NO SPAM“ sind unsere Klassen-Labels (y).

Während des Trainings unseres KI-Modells versucht der Algorithmus nun, die Merkmale bzw. Muster zu erkennen und zu lernen, die eine E-Mail möglichst genau als SPAM oder NO SPAM kategorisieren. Wenn wir im Anschluss dem fertig trainierten Modell die Eingabemerkmale einer neuen E-Mail geben, wird uns das Modell als Ausgabe eine Wahrscheinlichkeit oder einen Konfidenz-Score ausgeben, mit dem es die E-Mail als SPAM oder NO SPAM klassifizieren würde (z. B. 60 % SPAM und 40 % NO SPAM → Klasse SPAM).

Wer sich bereits mit Maschinellem Lernen auskennt oder meinen vorherigen Artikel gelesen hat, wird erkannt haben, dass es sich bei dem Beispiel um ein klassisches Beispiel für überwachtes Lernen handelt – und so ist es auch. In der Regel basieren diskriminative KI-Modelle auf einer Form des überwachten Lernens und ermöglichen die Lösung von Klassifikations- sowie Regressionsproblemen. Im Beispiel hatten wir ein typisches Klassifikationsproblem, bei dem das Modell eine Wahrscheinlichkeit für die Zugehörigkeit zu einer Klasse ausgibt. Genauso gehören jedoch auch Regressionsmodelle zur Familie der diskriminativen KI. Im Falle eines Regressionsproblems wäre die Ausgabe dann keine Wahrscheinlichkeit, sondern ein kontinuierlicher Wert (z. B. der Preis eines Hauses bei Eingabe der Hausmerkmale).

Mögliche Use-Cases

In der Praxis finden wir sehr viele Beispiele und Anwendungen, hinter denen in der einen oder anderen Form diskriminative KI steckt. Typische Beispiele und Use-Cases für diskriminative KI-Modelle sind beispielsweise:

-

Klassifizierung (z. B. von Bildern, Texten)

-

Scoring-Verfahren (z. B. zur Bewertung der Kreditwürdigkeit bei Banken)

-

Betrugserkennung (z. B. im Finanzwesen)

-

Empfehlungs- und Entscheidungssysteme (z. B. bei Amazon)

-

Objekt- und Bilderkennung (z. B. die Verkehrszeichenerkennung im Auto / autonomes Fahren)

-

Vorhersage von Maschinenfehlern oder Ausfällen (z. B. bei Industriemaschinen oder Sensorsystemen)

-

Kurs- und Zeitreihenprognosen (z. B. im Finanzwesen)

-

Churn-Prediction (z. B. im E-Commerce oder Marketing)

-

…

Generative KI

Kommen wir nun zur generativen KI, bei der es etwas anders aussieht. Generative KI-Modelle erzeugen als Ausgabe keine Klassenzugehörigkeiten oder einzelnen Werte, sondern völlig neue Texte, Bilder, Videos oder Audiodateien, die in ihrer Struktur und ihrem Stil den Trainingsdaten ähneln. Während ein diskriminatives Modell die bedingte Wahrscheinlichkeit P(y|x) lernt – also die Wahrscheinlichkeit für ein Label y bei gegebener Eingabe x –, modelliert ein generatives Modell die gemeinsame Wahrscheinlichkeitsverteilung P(x,y) der Daten. Vereinfacht gesagt: Es lernt die zugrundeliegende „Grammatik“ bzw. Statistik des gesamten Datensatzes, um anschließend selbstständig neue, plausible Beispiele aus dieser Verteilung zu „generieren“.

Nehmen wir wieder unser Spam-E-Mail-Beispiel: Ein diskriminatives Modell sagt, ob eine vorliegende E-Mail Spam ist. Ein generatives Modell hingegen (trainiert auf der gleichen Datenmenge) wäre in der Lage, komplett neue, authentisch wirkende E-Mails (Spam oder Nicht-Spam) zu verfassen, inklusive Betreffzeile, Inhalt und typischer Rechtschreibfehler. Seine Aufgabe ist nicht die Unterscheidung, sondern die Erzeugung neuer Inhalte.

In der Praxis gibt es generative KI-Modelle bereits seit längerer Zeit, jedoch ist die praktische Relevanz sowie die mediale Aufmerksamkeit erst seit der Veröffentlichung von ChatGPT (2022) „explodiert“ – getrieben durch große Fortschritte in der Architektur und dem Training der Modelle, insbesondere der Transformer-Architektur (Google 2017), Finetuning-Methoden wie RLHF (Reinforcement Learning from Human Feedback) und der Verfügbarkeit massiver Rechenkapazitäten.

Die populärsten generativen KI-Modelle bilden aktuell die Large Language Models (LLMs) wie OpenAIs GPT-4, Googles Gemini, Anthropics Claude oder Metas Llama sowie sogenannte Diffusionsmodelle zur Bildgenerierung wie Midjourney, DALL-E oder Stable Diffusion. Bei den LLMs handelt es sich überwiegend um sogenannte autoregressive generative KI-Modelle (Decoder), die einen Text Wort für Wort (bzw. tokenweise) vorhersagen, der auf Basis einer Eingabe (dem Prompt) statistisch am wahrscheinlichsten erscheint. Diffusionsmodelle erzeugen dagegen Bilder, indem sie schrittweise Rauschen aus einem Ausgangsbild entfernen und sich dabei an einer textuellen Beschreibung (dem Prompt) orientieren.

Die Gemeinsamkeit all dieser generativen KI-Systeme ist ihr Ziel, nicht eine Entscheidung zu treffen, sondern neue, strukturierte Inhalte zu erschaffen. Damit unterscheiden sie sich wesentlich von diskriminativen bzw. prädiktiven KI-Modellen.

Mögliche Use-Cases

Durch ihre Funktionsweise bieten sich generative KI-Modelle für eine Vielzahl von Anwendungen an, die mit diskriminativen Modellen nicht möglich wären. Typische Beispiele wären:

-

Content-Erstellung: Verfassen von Marketing-Texten, Artikeln, Produktbeschreibungen oder Social-Media-Posts.

-

Code-Generierung: Automatisches Schreiben von Code-Snippets, ganzen Funktionen oder die Übersetzung zwischen Programmiersprachen (z. B. GitHub Copilot).

-

Kreativ- und Designarbeit: Erstellen von Logo-Entwürfen, Marketing-Bildern, Architekturvisualisierungen oder kompletten Musikstücken.

-

Personalisierte Assistenz: Entwicklung hochgradig individueller Tutorensysteme, KI-gestützter Therapiegespräche oder personalisierter Avatare in Videospielen.

-

Forschung & Entwicklung: Generierung von Hypothesen, Beschleunigung von Literaturrecherchen oder Entwurf neuer Molekülstrukturen für die Pharmaforschung.

Info: Grundsätzlich kann man generative KI-Modelle auch für diskriminative Aufgaben wie Prognosen oder Klassifikation nutzen. Bedingt durch die Funktionsweise und das Training funktionieren diese jedoch anders und sind extrem schwer nachzuvollziehen.

Zusammenfassung – Diskriminative und Generative KI auf einen Blick

Da ich die Unterscheidung zwischen diskriminativer und generativer KI auf Basis meiner Erfahrungen in der Praxis als sehr wichtig und bedeutend erachte, folgt nun eine kurze Übersicht und Gegenüberstellung der charakteristischen Eigenschaften von diskriminativer und generativer KI:

Typische Charakteristiken und Eigenschaften von Diskriminativer KI

-

Datenqualität: Ergebnisse diskriminativer KI-Modelle sind immer nur so gut wie die für das Training vorhandenen Daten (Garbage in, Garbage out).

-

Aufgabenspezifität: Diskriminative KI-Modelle können in der Regel nur eine Aufgabe erfüllen und müssen für diese gesondert trainiert werden.

-

Individualität: Bei speziellen oder sensiblen Use Cases braucht es eigene Trainings- und Evaluierungsdaten und damit auch eigene Modelle.

-

Eingabedaten: Diskriminative KI-Modelle erwarten während der Inferenz (Nutzung) in der Regel standardisierte und strukturierte Eingabedaten, von denen nicht abgewichen werden darf.

-

Ausgabe: Diskriminative KI-Modelle geben Wahrscheinlichkeiten, Konfidenzintervalle oder kontinuierliche Werte in einem festen Ausgabeformat aus.

-

Nachvollziehbarkeit: Diskriminative Modelle sind – bedingt durch die jeweiligen Algorithmen – oft gut nachvollziehbar und interpretierbar (keine Blackbox).

-

Anwendungsbereich: Diskriminative KI-Modelle eignen sich überwiegend für Klassifikations- und Regressionsprobleme.

-

Determinismus: Diskriminative KI-Modelle sind deterministisch und reproduzierbar.

Typische Charakteristiken und Eigenschaften von Generativer KI

-

Aufgabe: Generative KI-Modelle synthetisieren neue Daten, anstatt vorhandene zu klassifizieren oder vorherzusagen.

-

Stochastische Ausgaben: Die Ausgaben sind in der Praxis stochastisch – bei wiederholter Eingabe des gleichen Prompts entstehen in der Regel unterschiedliche Ergebnisse (Variationen). Dies ist ein entscheidender Unterschied zu diskriminativen Modellen, die deterministisch sind.

-

Hinweis: Theoretisch sollten auch generative KI-Modelle deterministisch sein, da sie probabilistisch Ausgaben generieren. Das Problem ist jedoch, dass aufgrund der Größe der Modellparameter und Trainingsdaten die Wahrscheinlichkeitsunterschiede zwischen möglichen Ausgaben extrem klein sein können. In der Praxis führen bereits minimale numerische Rundungsfehler oder Abweichungen (z. B. auf unterschiedlicher Hardware) zu anderen Wortvorhersagen, wodurch die beobachteten Abweichungen erklärt werden können.

-

Generalisierungsfähigkeit: Sie besitzen ein hohes Maß an Generalisierungsfähigkeit; ein einziges großes generatives Modell (ein Foundation Model oder GPAI – General Purpose AI) kann für tausende unterschiedliche Aufgaben mittels Prompting angeleitet werden, ohne dass ein neues Training nötig ist.

-

Eingabedaten: Die Eingabedaten (Prompts) sind in der Regel unstrukturiert (natürliche Sprache) und unterliegen keinen festen Schemata.

-

Nachvollziehbarkeit: Die Nachvollziehbarkeit der Ausgaben ist eine große Herausforderung; generative Modelle können sogenannte Halluzinationen produzieren – also faktisch falsche, aber plausibel klingende Aussagen. Ihre Entscheidungsfindung ist für den Menschen oft eine Blackbox.

-

Anwendungsbereich: Sie eignen sich für kreative, inhaltserzeugende und assistierende Aufgaben, bei denen es keine eindeutige „richtige“ Antwort, sondern ein Spektrum plausibler Antworten gibt.

|

Merkmal |

Diskriminative KI |

Generative KI |

|---|---|---|

|

Grundlegende Aufgabe |

Unterscheidet, klassifiziert oder sagt Werte basierend auf vorhandenen Daten vorher. |

Synthetisiert und erzeugt neue, ursprünglich nicht vorhandene Daten. |

|

Ausgabecharakter |

Deterministisch: Gleiche Eingabe führt immer zum gleichen Ergebnis. |

Stochastisch (in der Praxis): Gleicher Prompt führt in der Regel zu unterschiedlichen Ergebnissen (Variationen). |

|

Anwendungsbereich |

Spezialisiert auf eine bestimmte Aufgabe (z.B. Klassifikation, Regression). |

Generalisierend: Ein einziges Modell (Foundation Model) kann für tausende verschiedene Aufgaben per Prompting genutzt werden. |

|

Art der Eingabe |

Erwartet standardisierte, strukturierte Daten; Abweichungen sind problematisch. |

Verarbeitet in der Regel unstrukturierte Eingaben (z.B. natürliche Sprache) ohne festes Schema. |

|

Art der Ausgabe |

Gibt Wahrscheinlichkeiten, Konfidenzintervalle oder kontinuierliche Werte in einem festen Format aus. |

Erzeugt komplexe, offeneInhalte wie Text, Bilder, Code usw. |

|

Nachvollziehbarkeit |

Gut nachvollziehbar und interpretierbar (keine Blackbox). |

Entscheidungsfindung ist oft eine Blackbox; anfällig für Halluzinationen (falsche, aber plausibel klingende Aussagen). |

|

Typische Einsatzgebiete |

Klassifikation (z.B. Spam-Erkennung), Regressionsanalyse (z.B. Preisfindung). |

Kreative Inhaltserstellung, Assistenzaufgaben, Texterstellung, wo es ein Spektrum plausibler Antworten gibt. |

|

Abhängigkeit von Daten |

„Garbage in, Garbage out“: Qualität stark von den Trainingsdaten abhängig. Benötigt spezielle Daten für spezielle Use Cases. |

Lernen aus extrem großen, allgemeinen Datensätzen; kann Wissen auf neue Aufgaben übertragen. |

|

Entwicklungsaufwand |

Muss für jede Aufgabe gesondert trainiert werden. |

Wird einmal als Basismodell trainiert und dann für verschiedene Aufgaben angepasst oder gepromptet. |

Praktische Relevanz mit Blick auf vertrauenswürdige und verantwortungsvolle KI

Warum ist nun die Unterscheidung zwischen starker/schwacher sowie diskriminativer/generativer KI in der Praxis relevant?

Wie eingangs erwähnt, dreht es sich bei vertrauenswürdiger und verantwortungsvoller KI im Kern um die Sicherstellung einer korrekten Funktionsweise sowie der Reduzierung und Behandlung möglicher Risiken, welche die Zuverlässigkeit, Sicherheit, Robustheit und damit die Qualität gefährden.

INFO: Ein qualitativ hochwertiges KI-System, das sicher, zuverlässig und robust ist, ist in der Regel gleichzeitig auch ein vertrauenswürdiges und verantwortungsvolles KI-System.

Der AI-Act definiert aus diesem Grund einen risikobasierten Ansatz. Der einfachste Weg, Risiken zu reduzieren, ist, diese nach Möglichkeit gar nicht erst aufkommen zu lassen. Dies beginnt bereits bei der Auswahl der KI. Nehmen wir diskriminative und generative KI-Modelle/Systeme: In der Zusammenfassung und Gegenüberstellung sehen wir bereits, dass generative KI-Modelle zwar vielseitig und einfacher einsetzbar sind (siehe ChatGPT), jedoch gleichzeitig auch deutlich mehr Angriffsvektoren und Risiken mit sich bringen. Halluzinationen, möglicher Missbrauch, Datenabfluss, Benachteiligung und Unfairness, mangelnde Qualität durch fehlende Daten oder unspezifisches Wissen – all dies sind mögliche Risiken, die adressiert werden müssen.

Auch wenn diskriminative KI-Modelle ebenso Risiken und Defizite aufweisen können, sind diese allein schon durch ihre Limitierung im Aufgabenumfang und bedingt durch ihre Funktionsweise einfacher zu adressieren. In der Regel müssen solche Modelle mit eigenen Daten trainiert und damit erstellt werden, was zwar deutlich größeren Aufwand bedeutet, aber auch maximalen Einfluss auf Transparenz, Kontrolle, Spezifität und Performance ermöglicht.

Damit kommen wir zur Einteilung in schwache und starke KI. Wenn der Use-Case auf die Ausführung einer einzelnen Aufgabe beschränkt ist und dies auch perspektivisch so bleibt (z. B. ein Absatzprognose-Modell), wäre dann vielleicht eine schwache KI, die durch ein diskriminatives KI-Modell umgesetzt wird, die bessere Wahl? Braucht es wirklich eine starke KI, die nebenbei noch fünf andere Aufgaben erledigen kann?

Tatsächlich gehörten vor der Veröffentlichung von ChatGPT bzw. LLMs KI-Modelle überwiegend der Kategorie der „schwachen“ bzw. diskriminativen KI an. Sie waren in der Regel individuell entwickelt bzw. trainiert, nur für eine Aufgabe optimiert, konnten diese Aufgabe dann aber häufig besser als Menschen lösen – bei maximaler Transparenz, Kontrolle und Einflussmöglichkeit. Der aktuelle mediale „Hype“ dreht sich im Grunde um KI-Systeme bzw. Modelle, die in die Kategorie der starken KI eingeordnet werden können und aktuell in der Regel durch generative KI-Modelle umgesetzt werden. Sie sind extrem vielseitig und generalistisch, jedoch in vielen Bereichen noch längst nicht so leistungsfähig wie ein Mensch und kommen mit vielen Chancen, aber auch deutlich mehr Risiken. Die EU führt solche Modelle im AI-Act unter dem Begriff der General Purpose AI (GPAI) und widmet ihnen einen eigenen Paragraphen mit weiteren Unterdefinitionen (Stichwort: GPAI mit systemischen Risiken).

Mit Blick auf mögliche Problemstellungen und den Einsatz von KI macht es deshalb häufig Sinn, sich zuerst zu fragen, ob ein generalistisches, starkes KI-Modell/System für den Use-Case die richtige Wahl ist oder nicht vielleicht doch ein schwaches, aber dafür spezialisiertes KI-Modell. Das Gleiche gilt für die Adressierung von Risiken und Qualitätsaspekten.

Aus diesem Grund halte ich das Wissen um starke und schwache sowie diskriminative und generative KI in der Praxis für extrem nützlich, da es sowohl bei der richtigen Auswahl als auch bei der Risikoabschätzung von neuen oder bestehenden KI-Systemen hilft.

Ich hoffe der Beitrag konnte einen Ein- und Überblick zu verschiedenen Arten von KI und deren Einordnung geben. Ich freue mich sehr über jedes Feedback, Verbesserungsvorschläge oder andere Erfahrungen und Meinungen.

Info: Während der Erstellung des Artikels habe ich für die Korrekturprüfung KI-Tools eingesetzt. Der Text und Inhalt wurde selbst verfasst.

0 Kommentare