Warum dieser Artikel?

Einleitung

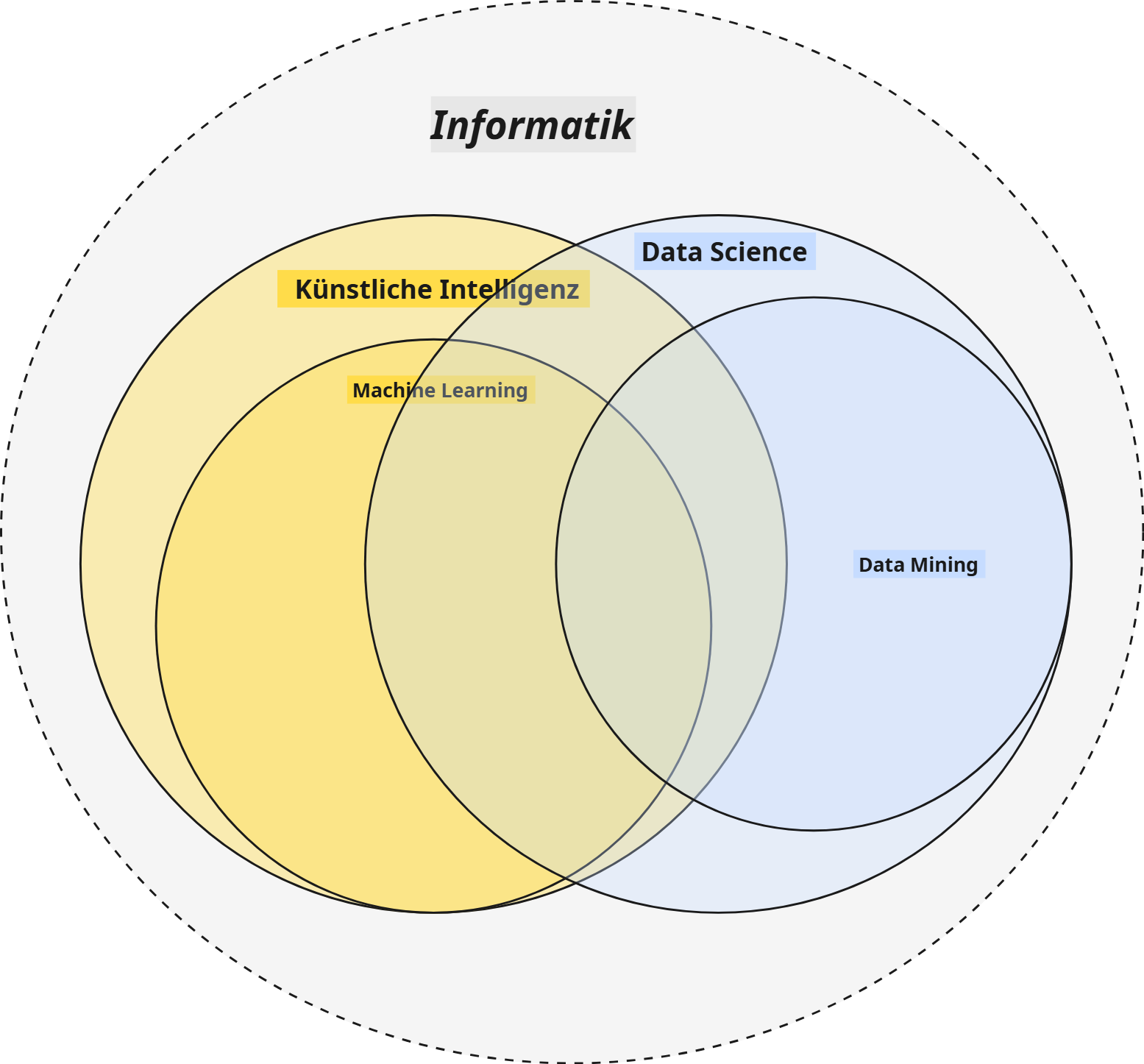

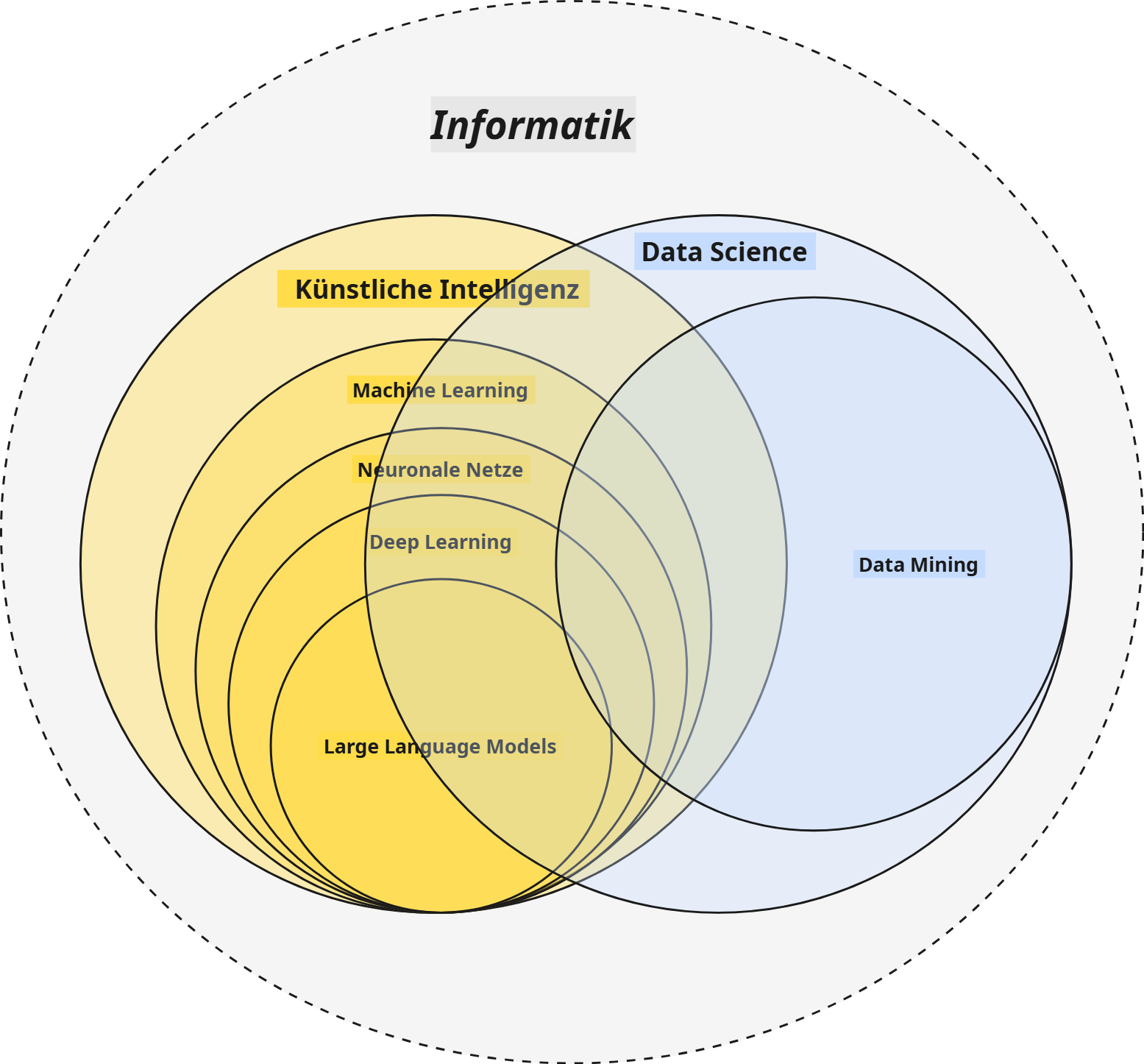

Wenn man von Künstlicher Intelligenz (KI) spricht, kommen schnell Begriffe wie Data Science, Data Mining, Machine Learning oder Deep Learning auf. Und tatsächlich gibt es viele Überschneidungen und Zusammenhänge. Um zu verstehen, wie und in welchen Punkten sich KI und KI-Systeme unterscheiden, ist es hilfreich zu verstehen, auf welchen zentralen Konzepten diese basieren oder in welchem Zusammenhang diese stehen.

In diesem Beitrag möchte ich deshalb mit den Grundlagen und Hintergründen zu zentralen Begriffen und Themen im Kontext KI beginnen, um ein klares Verständnis für ihre jeweiligen Rollen und ihren Beitrag zum übergeordneten Feld der KI zu schaffen.

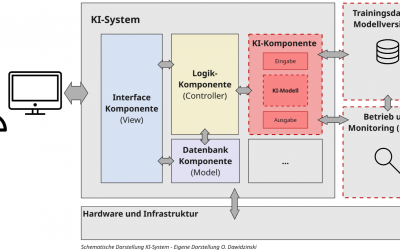

Bei der verantwortungsvollen Nutzung oder Entwicklung von vertrauenswürdigen KI-Systemen spielt KI-Kompetenz eine Schlüsselrolle. Im Rahmen der KI-Verordnung (EU AI Act) ist diese seit Februar 2025 sogar verpflichtend. Im Rahmen meiner Artikelserie zum Thema „KI-Kompetenz“ möchte ich die Inhalte teilen, welche aus meiner Sicht für eine solide KI-Kompetenz zur verantwortungsvollen Nutzung und Entwicklung von vertrauenswürdigen KI-Systemen relevant sind.

Mehr zur Thematik KI-Kompetenz (AI-Literacy) in folgendem Beitrag: KI-Kompetenz (Teil 1): Grundlage für verantwortungsvolle KI

Inhalt und Aufbau des Artikels

In diesem Artikel möchte ich auf folgende Punkte eingehen:

- Data Science

- Data Mining

- Maschinelles Lernen (ML)

- Überwachtes Lernen

- Unüberwachtes Lernen

- Verstärkendes Lernen

- Teilüberwachtes Lernen

- Selbstüberwachtes Lernen

- Neuronale Netze und Deep Learning

- Statistische Modelle und entscheidungsbaumbasierte Algorithmen

- Künstliche Neuronale Netze

- Tiefe Neuronale Netze

- Large Language Models

- Künstliche Intelligenz

Data Science

Beginnen wir mit der Data Science. Sie ist ein multidisziplinäres Feld, bei dem es im Kern darum geht, aus Rohdaten Wissen und Erkenntnisse zu generieren. Data Scientists sammeln, bereinigen und analysieren Daten, um Antworten auf komplexe Fragen zu finden. Dazu werden häufig statistische Methoden, unterschiedliche Algorithmen, Programmiersprachen wie Python und Visualisierungstools genutzt, um zum Beispiel Trends zu erkennen – etwa um Vorhersagen für Unternehmensstrategien zu treffen oder Kundenbedürfnisse zu verstehen. Innerhalb der Data Science versucht man somit, Probleme und Fragestellungen datengetrieben zu lösen.

Dabei bedient sich die Data Science zur Analyse und Wissensgewinnung häufig bei Algorithmen und Verfahren der Künstlichen Intelligenz beziehungsweise des Maschinellen Lernens. Umgekehrt wird zur Entwicklung von KI-Systemen und Modellen häufig auf Verfahren und Techniken der Data Science zur Datenselektion und Vorbereitung zurückgegriffen. Aus diesem Grund können Data Science und KI sehr viele Schnittmengen haben, obwohl sie grundsätzlich unterschiedliche Schwerpunkte und damit Zielsetzungen verfolgen.

Data Mining

Eine zentrale Rolle zur Wissensgewinnung innerhalb der Data Science spielt das Data Mining. Als Teilgebiet der Data Science geht es hier darum, Muster in großen Datenmengen aufzudecken und zu analysieren. Man stelle sich zum Beispiel ein Einzelhandelsunternehmen vor, welches Millionen von Verkaufsdatensätzen analysiert: Im Rahmen eines Data Mining würde man versuchen, in den Daten Zusammenhänge zu finden (z. B. „Wer Windeln kauft, kauft oft auch Bier“). Im Data Mining nutzt man häufig Algorithmen aus der Statistik oder dem Maschinellen Lernen (welches ein Teilbereich der KI ist), um zum Beispiel automatisch Auffälligkeiten, Cluster oder Trends zu identifizieren. Data Mining ist somit eine zentrale Unterdisziplin – ein Werkzeug innerhalb der Data Science zur datengetriebenen Lösung von Problem- und Fragestellungen.

Maschinelles Lernen (ML)

Kommen wir nun zum Maschinellen Lernen (ML). Das Maschinelle Lernen ist ein Teilbereich der Künstlichen Intelligenz mit dem Ziel, durch verschiedene Algorithmen aus Daten „zu lernen“, um Vorhersagen oder Entscheidungen zu treffen – und das, was ganz wichtig ist, ohne explizit dafür programmiert worden zu sein (wie es bei klassischen regelbasierten Systemen häufig der Fall wäre). Ein ML-Modell wäre damit zum Beispiel in der Lage, auf Basis von historischen Wetterdaten die Wahrscheinlichkeit für zukünftige Wetterereignisse vorherzusagen. Je nach Problem und Anwendungsgebiet des Maschinellen Lernens kommen unterschiedliche Verfahren und Herangehensweisen zum Einsatz, weswegen man das Maschinelle Lernen grundsätzlich in folgende Unterkategorien einteilt:

Überwachtes Lernen (Supervised Learning)

Beim überwachten Lernen (Supervised Learning) lernt ein Modell aus Beispielen, für die jeweils die richtige Lösung (ein Label) vorhanden ist. Das Lernprinzip ist vergleichbar mit Karteikarten, bei denen zu jeder Frage immer die richtige Antwort auf der Rückseite steht. Das ML-Modell versucht während des Trainingsprozesses anhand der Eigenschaften der Objekte auf das richtige Label zu schließen und dieses zu lernen. Supervised Learning ist sehr effektiv, wenn ausreichend Trainings- und Testdaten vorhanden sind, für die gleichzeitig Labels beziehungsweise die Werte, welche vorhergesagt werden sollen, vorliegen. Bei den Algorithmen unterscheidet man grob zwischen linearen und nicht-linearen Verfahren, wie zum Beispiel Regressionsverfahren oder Entscheidungsbäume und neuronale Netze.

Unüberwachtes Lernen (Unsupervised Learning)

Das unüberwachte Lernen (Unsupervised Learning) ist im Grunde das Gegenteil vom überwachten Lernen. Während bei diesem für jedes einzelne Datenobjekt eine Zielvariable (das Label) vorhanden war, anhand dessen der Algorithmus vergleichen konnte, sind beim unüberwachten Lernen keinerlei Klassenzugehörigkeiten oder bezeichnende Werte für die einzelnen Datenobjekte vorhanden. Ziel des unüberwachten Lernens ist es nun, selbstständig auf Basis der Eigenschaften der einzelnen Datenpunkte Muster zu identifizieren, anhand derer ähnliche Datenpunkte identifiziert und geclustert werden können. Einer der häufigsten Anwendungsfälle im unüberwachten Lernen ist tatsächlich die Identifizierung von Gruppen beziehungsweise Clustern, um zum Beispiel Kundengruppen mit ähnlichen Eigenschaften zu identifizieren, denen man dann am Ende eine Gruppenzugehörigkeit zuweisen kann (ein Label verpasst). Man spricht deshalb beim unüberwachten Lernen häufig auch von Clusteranalysen, auch wenn es deutlich mehr Anwendungsfälle gibt.

Verstärkendes Lernen (Reinforcement Learning)

Beim verstärkenden Lernen (Reinforcement Learning) setzt man Algorithmen ein, welche versuchen, ein Ziel selbstständig durch Trial-and-Error zu erreichen. Man definiert dazu ein Ziel, bestimmte Grenzen und eine Kostenfunktion und lässt dann den Algorithmus alle möglichen Lösungsoptionen durchiterieren, bis er eine mögliche Lösung zum Erreichen des Ziels gefunden hat. Bei jedem Fehlversuch lernt das System und versucht einen neuen (ähnlich wie wir Menschen, wenn wir zum Beispiel in einem Videospiel versuchen würden, einen Endgegner zu bewältigen und dazu verschiedene Strategien ausprobieren). Typische Anwendungsfelder sind deshalb häufig in der Robotik, Videospielen (Gegner-KI) oder speziellen Post-Trainings-Methoden im generativen KI-Bereich zu finden.

Teilüberwachtes Lernen (Semi-Supervised Learning)

Das teilüberwachte Lernen (Semi-Supervised Learning) ist eine Sonderform des überwachten Lernens (Supervised Learning), bei dem sowohl eine kleine Menge an gelabelten (beschrifteten) Daten als auch eine große Menge an ungelabelten (unbeschrifteten) Daten für das Training eines Modells verwendet werden. Es stellt somit einen Mittelweg zwischen dem überwachten und dem unüberwachten Lernen dar. Der Hauptvorteil besteht darin, dass die Kosten und der Aufwand für die Beschaffung von gelabelten Daten, die oft sehr zeit- und ressourcenintensiv sind, reduziert werden können, während gleichzeitig die Genauigkeit des Modells durch die Nutzung der zusätzlichen Informationen aus den ungelabelten Daten verbessert wird.

Das selbstüberwachte Lernen (Self-Supervised Learning)

Beim selbstüberwachten Lernen (Self-Supervised Learning) handelt es sich ebenfalls um eine Sonderform des überwachten Lernens, die jedoch aktuell insbesondere im Bereich der generativen KI große Bedeutung hat. Bei dieser Lernmethode generiert das Modell seine eigenen Labels (die richtigen Antworten oder Lösungen) aus einem Datensatz, für den vorher keine Labels erstellt wurden. Anders als beim Karteikartenbeispiel aus dem klassischen überwachten Lernen, bei dem zu jeder Frage auf der Rückseite von einem Menschen die richtige Antwort (Label) geschrieben sein muss, lernt das System selbstständig durch die Vorhersage fehlender oder verdeckter Teile einer Eingabe. Dies kann man sich vorstellen, wie bei einem Satz, bei dem man immer das nächste Wort abdeckt und der Algorithmus versuchen muss, auf Basis der vorherigen Wörter im Satz auf das abgedeckte zu schließen. Der Vorteil ist, dass bei diesem Verfahren kein Mensch zur Annotation benötigt wird und der Algorithmus sich selbst die Texte „aus- und wieder einblendet“ und damit selbst überwacht. Aus diesem Grund spricht man vom selbstüberwachten Lernen. Dieses Verfahren ist deshalb so bedeutend, da die aktuellen Large Language Models (LLMs) (dazu gleich im nächsten Absatz mehr) im Grunde alle auf diesem Basisprinzip (dem sogenannten Pre-Training) funktionieren.

Als Grundlage der künstlichen Intelligenz und durch seine Vielseitigkeit als Werkzeug innerhalb der Data Science und des Data Minings kommt dem maschinellen Lernen eine besondere Bedeutung zu. Wie Neuronale Netze und Deep Learning mit dem Maschinellen Lernen in Verbindung stehen, dazu kommen wir jetzt.

Neuronale Netze und Deep Learning

Wenn man von maschinellem Lernen spricht, fallen unweigerlich auch die Begriffe der Neuronalen Netze oder des sogenannten Deep Learning. Dies hat einen engen Zusammenhang: Innerhalb des maschinellen Lernens gibt es, unabhängig von den unterschiedlichen Anwendungskategorien, eine weitere Möglichkeit der Unterkategorisierung. Hierbei wird nach Art und Technologie der verwendeten Algorithmen und Verfahren unterschieden, die zum Einsatz kommen. Der Hintergrund ist, dass sich im Laufe der Zeit unterschiedliche Technologien und Algorithmen entwickelt haben, welche jedoch nach wie vor jeweils gesondert ihre Daseinsberechtigung und Anwendungsgebiete haben und damit koexistieren.

Die wesentlichen Kategorien, in welche Algorithmen des maschinellen Lernens eingeteilt werden können, sind die folgenden:

Statistische Modelle und entscheidungsbaumbasierte Algorithmen (ML)

Dies sind die ursprünglichen Verfahren und Basiswerkzeuge im Werkzeugkasten von Data Scientists oder Wissenschaftlern. Sie umfassen sowohl lineare als auch nicht-lineare Modelle und Algorithmen, wie logistische Regression, Entscheidungsbäume, AR-Modelle, Support-Vektor-Machines oder Gradienten- und Boosting-Verfahren. Diese sind sehr vielfältig und bieten häufig die Möglichkeit, ML-Modelle mit überschaubarem Aufwand zu trainieren und zu entwickeln. Viele dieser Algorithmen erreichen auch nach wie vor State-Of-The-Art (SOTA) Performance für unterschiedliche Anwendungsfälle. Dabei haben solche Modelle den entscheidenden Vorteil, dass sie grundsätzlich gut zu interpretieren sind und die Entscheidungsfindung (warum eine Vorhersage getroffen wird) leichter nachvollzogen werden kann. Aus diesem Grund werden solche Algorithmen häufig als „White-Box„-Modelle bezeichnet. Diese Eigenschaft macht sie im Rahmen von vertrauenswürdigen KI-Systemen extrem wertvoll und ist der Grund, warum in besonders regulierten Bereichen nach wie vor „einfache“ statistische Modelle als Grundlage für KI-Systeme genutzt werden, um Nachvollziehbarkeit zu gewährleisten.

Künstliche Neuronale Netze (Artificial Neural Networks)

Die Idee, durch künstliche neuronale Netze die Funktionsweise des Gehirns nachzubilden, geht bereits bis in die 1950er Jahre zurück. Leistungsbedingt haben die Verfahren jedoch erst Anfang der 2000er Jahre ihren breiten Einsatz gefunden. Neuronale Netze sind komplexe Algorithmen, welche durch ihre Funktionsweise versuchen, das menschliche Gehirn nachzubilden. Sie gehören zur Kategorie der nicht-linearen Modelle und besitzen damit die Fähigkeit, auch komplexe Muster in Eingangsdaten abzubilden, was sie zu sehr starken Algorithmen und Verfahren macht. Durch ihre Komplexität und Funktionsweise ist es bei neuronalen Netzen jedoch häufig schwierig, die genaue Funktionsweise (bzw. interne Parametrisierung) zu analysieren und zu verstehen. Dies macht sie häufig zu sogenannten „Blackbox-Modellen„.

Tiefe Neuronale Netze (Deep Learning)

Die tiefen neuronalen Netze sind eine Weiterentwicklung der künstlichen neuronalen Netze, bei welchen vereinfacht gesagt, weitere Verarbeitungsschichten (Neuronen) eingefügt wurden. Dadurch sind solche Modelle in der Lage, noch besser Muster und nicht-lineare Zusammenhänge zu erfassen. Gleichzeitig erhöht sich dadurch jedoch auch die Komplexität und der Ressourcenaufwand für das Training solcher Modelle. Zudem wird die Interpretierbarkeit solcher Systeme weiter erschwert. Obwohl Deep-Learning-Modelle universell einsetzbar sind, zeigen diese besonderes Potenzial in der Bild- und Objekterkennung und finden dort weite Verbreitung.

Large Language Models (Transformer)

Large Language Models (LLMs) sind die Begründer der disruptiven Entwicklung im Bereich der generativen KI (GenAI) und dem Hype hinter Anwendungen wie ChatGPT. Bei Large Language Models handelt es sich um eine Weiterentwicklung bzw. spezielle Form des Deep Learning, welche auf der sogenannten Transformer-Architektur basiert. Die Transformer-Architektur ermöglicht es den LLMs, nicht nur einzelne Wörter zu verstehen, sondern auch den Kontext und die Beziehungen zwischen Wörtern über lange Textabschnitte hinweg zu erfassen. Dadurch sind LLMs in der Lage, menschenähnliche Texte, Bilder oder Inhalte zu generieren, zu übersetzen, zusammenzufassen, Fragen zu beantworten und sogar Code zu schreiben.

Künstliche Intelligenz

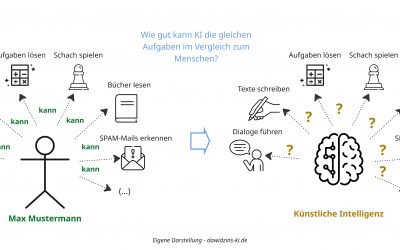

Kommen wir nun zur künstlichen Intelligenz (KI). Das übergeordnete Ziel der KI ist es, Systeme zu schaffen, welche in der Lage sind, menschliche Intelligenz nachzuahmen. Dabei bedient sich die KI einer Vielzahl unterschiedlicher Techniken und Verfahren des maschinellen Lernens. Das maschinelle Lernen kann somit als das Rückgrat der künstlichen Intelligenz betrachtet werden. Insbesondere die Large Language Models (LLMs) hatten und haben im Bereich der generativen KI (GenAI) einen maßgeblichen Einfluss auf die aktuelle Entwicklung und die Fortschritte im Bereich der künstlichen Intelligenz.

Während viele maschinelle Lernverfahren und Algorithmen bereits hervorragende Ergebnisse bei der Verarbeitung von tabellarischen und strukturierten Daten erzielten, konnten diese jahrelang nur sehr eingeschränkt im Bereich der natürlichen Sprache (NLP) eingesetzt werden – eine bis dahin große Einschränkung im Kontext der künstlichen Intelligenz.

Mit der Einführung der Transformer-Architektur und den darauf basierenden LLMs hat sich dies grundlegend geändert und damit ganz neue Anwendungsmöglichkeiten und Potenziale eröffnet. Letztendlich sind sie es auch, welche hinter den aktuellen Entwicklungen und dem großen medialen Echo stehen, und wenn man in den Medien von KI hört, ist damit überwiegend generative KI auf Basis von Large Language Models gemeint.

Warum dies so ist, was der Unterschied zwischen generativer und prädiktiver KI ist und wie sich KI weiter unterteilen lässt, darauf gehe ich im dritten Teil meiner KI-Kompetenz-Serie ein.

0 Kommentare